Trong thời đại công nghệ 4.0 như ngày nay, mọi người đều tận dụng tối đa công nghệ và tìm cách đổi mới. Một số trang web có thể chứa lượng lớn thông tin mật. Và nếu muốn truy cập vào những thông tin này, bạn phải sử dụng web scraping? Vậy web scraping là gì và có những tính năng nào? Hãy cùng tìm hiểu tất tần tật thông tin qua bài viết dưới đây nhé.

Web scaping là gì?

Web scraping (hay còn được gọi là trích xuất dữ liệu web hoặc thu thập dữ liệu) là quá trình sử dụng các con bots (phần mềm máy tính thực hiện các tác vụ tự động) để trích xuất dữ liệu và nội dung từ các website. Những dữ liệu sau khi được thu thập sẽ được lưu thành các định dạng hữu ích như bảng tính hoặc truy xuất bằng API cho nhiều mục đích khác nhau. Và những công cụ phục vụ cho web scraping gọi là web scraper.

Không giống như screen scraping, chỉ sao chép những pixel hiển thị trên màn hình. Mà web scraper sẽ trích xuất các mã HTML của website và lấy ra phần thông tin hữu ích ẩn trong đó.

Web Scraping hoạt động như thế nào?

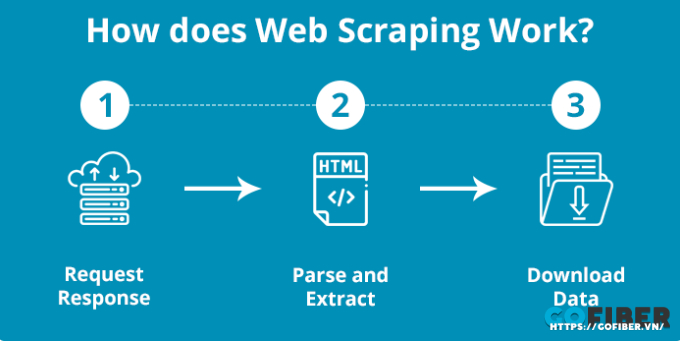

Vậy cách hoạt động của web scraping là gì? Các trình duyệt web hoạt động theo một cách đơn giản nhưng đôi khi cũng hơi phức tạp.

Đầu tiên, trình duyệt web sẽ được cung cấp cho một hoặc nhiều đường link để tải trước khi scrape. Sau đó, scraper sẽ tải tất cả HTML cho các trang được đề cập. Các công cụ scraper nâng cao hơn sẽ hiển thị toàn bộ trang web, bao gồm các phần tử CSS và Javascript.

Tiếp theo, scraper sẽ trích xuất tất cả dữ liệu có trên trang và dữ liệu cụ thể được người dùng chọn trước khi chạy. Người dùng sẽ được tiến hành quá trình chọn dữ liệu cụ thể muốn chọn từ website. Chẳng hạn, như bạn có thể scrape trang Amazon để biết về giá cả và mẫu mã nhưng không cần thiết phải quan tâm đến các bài đánh giá sản phẩm.

Cuối cùng, web scraper sẽ xuất toàn bộ dữ liệu đã thu thập được sang một định dạng có ích hơn cho người dùng. Hầu hết các web scraper sẽ xuất dữ liệu sang định dạng CSV hoặc Excel Spreadsheet. Trong khi đó, các scraper nâng cao sẽ hỗ trợ các định dạng như JSON để sử dụng cho một API.

Các loại Web Scraper phổ biến

Hiện nay, có 4 loại web scraper phổ biến

Self-built or Pre-built

Cũng giống như cách xây dựng website, bất cứ ai cũng có thể tạo web scraper của riêng mình. Thế nhưng, với các công cụ có sẵn để xây dựng web scraper vẫn yêu cầu các kiến thức lập trình nâng cao. Phạm vi kiến thức cũng sẽ tăng lên theo số lượng các tính năng mà bạn muốn có cho scraper của mình.

Ngoài ra, cũng có rất nhiều công cụ web scraper prebuilt khác để bạn có thể tải xuống và chạy ngay lập tức. Các công cụ này cũng sẽ được bổ sung một vài tùy chọn nâng cao như scrape scheduling, xuất file JSON và Google Sheet,...

Browser extension vs Software

Nhìn chung, web scraper có 2 dạng chính là browser extension và software. Browser extension là những chương trình giống như ứng dụng có thể thêm vào trình duyệt, như Google Chrome hoặc Firefox. Có thể kể đến một vài browser extension như chủ đề, chặn quảng cáo, tiện ích nhắn tin,... Web scraping extension có ưu điểm là chạy đơn giản hơn và được tích hợp ngay trong trình duyệt của bạn. Thế nhưng, các tiện ích này thường bị giới hạn bởi nằm trong trình duyệt của bạn. Điều đó có nghĩa là với bất cứ tính năng nâng cao nào phải xuất hiện bên ngoài thì không thực hiện được.

Ngoài ra, bạn cũng có web scraping software có thể tải xuống và cài đặt ở trong máy tính. Mặc dù các tiện ích này không tiện lợi bằng browser extension, nhưng lại bù đắp ở các tính năng nâng cao không bị giới hạn.

User Interface

Một số web scraping chạy với UI (User Interface) tối thiểu là một dòng lệnh. Điều này khiến một số người dùng có thể thấy hơi khó hiểu và không trực quan. Thế nhưng, một số công cụ web scraper có UI chính thức và là nơi website được hiển thị đầy đủ để người dùng chỉ cần nhấp vào dữ liệu muốn thu thập. Những công cụ scraper này thường dễ tiếp cận hơn với những người có kiến thức kỹ thuật hạn chế. Một số scraper sẽ làm tốt hơn khi tích hợp được các mẹo và đề xuất trợ giúp thông qua UI để đảm bảo người dùng hiểu được các tính năng mà phần mềm cung cấp.

Cloud vs Local

Web scraper cục bộ (local) sẽ chạy trên máy tính bằng cách sử dụng các nguồn tài nguyên và kết nối với Internet. Điều đó có nghĩa là nếu web scraper có mức sử dụng CPU và RAM cao, máy tính có thể khá chậm trong khi scraper chạy khá nhanh. Với các scraping task dài có thể khiến máy tính không thể hoạt động tốt trong nhiều giờ. Ngoài ra, nếu scraper của bạn được xây dựng để chạy trên một số lượng lớn link URL thì có thể tác động đến giới hạn dữ liệu của bạn.

Còn cloud web scraper chạy trên một server bên ngoài website và thường được cung cấp bởi công ty đã phát triển công cụ scraper này. Điều này có nghĩa là tài nguyên máy tính sẽ được giải phóng, trong khi scraper chạy và thu thập dữ liệu. Nhờ vậy, bạn có thể làm các task khác và được thông báo sau khi scrape của bạn đã sẵn sàng để xuất dữ liệu. Điều này cũng cho phép tích hợp thêm các tính năng nâng cao như IP rotation, để ngăn scraper của bạn không bị chặn khỏi các website.

Cách phát hiện và ngăn chặn Web Scraping độc hại

Web scraping là một công cụ mạnh mẽ giúp tự động hóa việc thu thập dữ liệu. Thế nhưng, nếu sử dụng sai mục đích thì có thể dẫn tới đánh cắp tài sản trí tuệ hoặc cạnh tranh không lành mạnh. Thế nên, chủ website có thể ứng dụng các phương pháp sau để phân loại các con bots, bao gồm cả scraping bots

- Sử dụng file robots.txt: Có thể sử dụng robots.txt để bảo vệ website trước các scraping bots. Thế nhưng cần cân nhắc hiệu quả về lâu dài. Bởi đây là tệp tin hướng dẫn các con bot thực hiện theo các luật định sẵn. Và một vài con bot độc hại sẽ tìm kiếm thông tin trong file robots.txt. Đây là trang quản trị và chủ website không muốn Google khai thác.

- Sử dụng CAPTCHA: Một số website sẽ sử dụng CAPTCHA để phân biệt người dùng thực và bot để ngăn chặn một vài kiểu tấn công. Phần lớn bot sẽ liên kết với một chương trình như Chrome, JavaScript hay Internet Explorer. Nếu bot hoạt động khác với những chương trình này thì có thể bị phát hiện và ngăn chặn

- Giới hạn tần suất truy cập: Không bỏ qua những lưu lượng truy cập bất thường trên một vài sản phẩm. Chủ website cần giám sát để phát hiện lượng truy cập cao bất thường và giới hạn tần suất truy cập

- Phân tích lưu lượng mạng: Một cách khác để ngăn chặn web scraping chính là sử dụng công cụ kiểm soát và phân tích lưu lượng truy cập độc hại trên Internet. Chẳng hạn như Imperva sẽ giúp phát hiện và vô hiệu hóa những con bot độc hại.

- Theo dõi và xử lý kịp thời: Theo dõi các khách hàng truy cập tương tác với một website để thấy những hành vi bất thường. Chẳng hạn như tỷ kiểu duyệt web phi logic hay tỷ lệ yêu cầu đăng nhập web một cách đáng ngờ. Điều này giúp phát hiện ra những con bot đang truy cập vào website

- Sử dụng công nghệ giám sát: Người dùng sẽ sử dụng các công cụ phân tích, đánh giá và kiểm tra cấu trúc của các web request kết hợp cùng dữ liệu của các con bot trả về. Chủ website có thể xác định được đâu là con bot cần phải ngăn chặn.

Đánh giá và vấn đề liên quan đến Web Scraping

Việc thu thập thông tin từ cơ sở dữ liệu có thể được sử dụng với các mục đích xấu như ăn cắp sở hữu trí tuệ, bảng giá và danh sách khách hàng,... Chúng ta cần nhìn lại thực tế sử dụng và vấn đề pháp lý của web scraping. Không phải tất cả việc thu thập thông tin trên web đều xấu. Ví dụ về việc thu thập thông tin hợp pháp thường được hỗ trợ bởi bot bao gồm các trang web tổng hợp chẳng hạn như trang web du lịch, cổng đặt phòng khách sạn và trang web bán vé buổi hòa nhạc. Các bot phục vụ nội dung từ các trang web này lấy dữ liệu thông qua API hoặc trích xuất dữ liệu từ trang web và thường hướng lưu lượng truy cập đến trang web của chủ sở hữu dữ liệu. Trong trường hợp này, bot có thể đóng một vai trò quan trọng trong mô hình kinh doanh của các doanh nghiệp.

Mặc dù hoạt động thu thập dữ liệu dựa trên web là phổ biến nhưng ý nghĩa pháp lý của hoạt động này vẫn chưa rõ ràng. Nhiều luật có thể áp dụng cho việc thu thập thông tin trái phép, bao gồm luật thương mại và bản quyền. Vì các bot thu thập thông tin cũng có thể gây hại cho doanh nghiệp nên chúng tôi cần tạo một hệ sinh thái vừa thân thiện với bot vừa có thể chặn các ứng dụng tự động độc hại. Chủ sở hữu trang web có thể cải thiện đáng kể tính bảo mật của trang web của họ bằng cách chặn các bot xấu mà không loại trừ các bot hợp pháp.

Với những thông tin trên, hy vọng bạn đã phần nào trả lời được câu hỏi web scraping là gì? Với những gì mà web scraping đang làm được thì đây là một cách thức thu thập thông tin cực hữu ích và nhanh chóng. Thế nhưng, nếu không được sử dụng đúng cách thì cũng gây ảnh hưởng xấu.